Principes de l'IA responsable et régulation de l'UE

L'IA inquiète beaucoup de monde. Cette inquiétude s'est amplifiée progressivement depuis la médiatisation extrême de ChatGPT.

Pourquoi cette inquiétude ?

Cela vient du type d'IA générative qu'est ChatGPT : une IA générative qui cumule la capacité à discuter et exécuter de nombreuses autres tâches.

Les IA génératives sont capables de beaucoup de choses : faire des traductions, mais on était déjà habitué depuis longtemps à des traducteurs automatiques comme Google Traduction. Elles sont aussi capables de répondre à des questions sur presque tous les sujets ou d'agir sur instructions. On était déjà aussi habitué à Alexa ou Siri.

ChatGPT cumule toutes ces capacités, il ringardise Alexa et Siri. La nouveauté est vraiment la partie dialogue, avec prise en compte du contexte et de l'historique du dialogue. Ces améliorations ont existé grâce aux Réseaux de Neurones Récurrents, des réseaux de neurones qui tiennent compte du temps ou d'une forme de séquentialité, puis grâce aux Transformers avec mécanisme d'attention. Cela donne l'illusion d'une vraie forme d'intelligence et de raisonnement, donnant l'impression qu'on a affaire à une personne.

Donc tout le monde se projette dans un imaginaire collectif véhiculé par des films de science fiction , des séries télévisées, des romans d'anticipation. Ces productions sont souvent associées à des formes de cataclysme, d'apocalypse, de retournement de la machine contre l'homme.

Les réactions dans la presse et sur les réseaux sociaux ont témoigné d'une personnification extrême de ChatGPT :

- ChatGPT poursuivi en justice

- ChatGPT devient prêtre

- ChatGPT est nul en maths

Même le champs sémantique autour de ChatGPT pousse à la personnification : on parle de « hallucination ». Tout le monde parle de ChatGPT comme si c'était un humain, un individu à part entière, alors que ce n'est qu'un algorithme, certes complexe, basé sur des principes inspirés du cerveau humain, et associé à des quantités astronomiques de données initialement générées par des humains. Mais ChatGPT n'essaie pas d'être un humain et ne se comporte pas comme un humain. Il est donc inutile de lui faire passer le test de Turing (certains ont essayé).

Les IA génératives sont une classe d'outils vraiment disruptive, et dont les répercussions sont encore imprévisibles. Imprévisibles au même titre qu'ont pu l'être de nombreuses autres innovations comme l'imprimerie, le moteur à pétrole, l'internet, qui ont à leur époque ont apporté leur lot d'inquiétudes, liées entre autres à des risques juridiques, éthiques, politiques, sociétaux.

L'IA responsable selon les grands acteurs du domaine

Pour répondre à cette angoisse collective, qui vient s'ajouter à de nombreuses autres angoisses actuelles propagées par les media et les réseaux sociaux, les éditeurs d'IA générative essaient de donner l'impression qu'ils ont compris et qu'ils agissent avec des principes ou qu'ils ne sont pas diaboliques (en anglais : evil) comme disait Google à ses débuts.

Faisons donc un tour des communications censées êtres rassurantes de quelques grands acteurs de l'IA générative.

En 2018 l'éditeur de Bard a donné ses principes de l'IA responsable.

Une IA responsable doit :

- Être bénéfique à la société

- Éviter les biais injuste envers les gens

- Être construite et testée pour la sûreté

- Être redevable envers les gens

- Incorporer des principes de conception de confidentialité

- Défendre des standards élevés d'excellence scientifique

- Être rendue disponible pour des usage en accord avec ces principes

OpenAI

Du côté des créateurs de ChatGPT, on trouve surtout des déclarations et des citations, sur l'alignement avec les intentions humaines. Et qu'il n'est pas trop tard pour guider la trajectoire et limiter les abus. Ça ressemble un peu à des déclarations tardives une fois que tout le monde s'inquiète.

Un peu comme Google, on trouve également des principes, au nombre de quatre :

- Minimiser les dommages

- Bâtir la confiance

- Apprendre et itérer

- Être pionnier dans la confiance et la sécurité

Microsoft

Chez Microsoft, auteur de Bing AI on trouve les 6 principes suivants :

- Équité

- Inclusion

- Fiabilité et sécurité

- Transparence

- Confidentialité et sécurité

- Redevabilité

La régulation de la Commission Européenne

Pendant ce temps, évitant de faire trop confiance aux déclarations de bonnes intentions ci-dessus, l'Europe essaie de comprendre, de s'adapter, de faire son boulot de régulateur.

les personnes et les entreprises devraient pouvoir profiter des avantages de l’IA tout en se sentant en sécurité et protégées

veiller à ce que l’IA soit centrée sur l’humain et digne de confiance

La page pointe vers un livre blanc qui se découpe en gros en deux parties : promouvoir et réguler :

- Comment promouvoir l'IA ;

- Comment proposer un cadre de régulation pour les applications à haut risque, comme le recrutement ou l'identification biométrique à distance.

Promouvoir l'IA

- Proposer une révision d'un précédent Plan Coordonné sur l'IA.

- Faciliter la création de centres d'excellence et de test pour combiner les investissements européens, nationaux et privés, éventuellement en incluant un nouvel instrument juridique.

- Établir et soutenir des réseaux d'enseignement supérieur pour attirer les meilleurs professeurs et scientifiques et proposer des programmes de renommée mondiale en intelligence artificielle.

- Veiller à ce qu'au moins un pôle d'innovation numérique par État membre ait un degré élevé de spécialisation en IA.

- Mettre en place un partenariat public-privé en matière d'IA, de data et de robotique, coordonner la recherche et l'innovation en IA, collaborer avec d'autres partenariats public-privé et les pôles d'innovation numérique mentionnés ci-dessus.

- Lancer des dialogues sectoriels sur la santé, les administrations rurales et les opérateurs de services publics, afin de présenter un plan de développement, d'expérimentation et d'adoption de l'IA.

Réguler les applications à haut risque

Le régulation doit porter sur :

- Les données d'entrainement, leur nature, leur diversité pour éviter des biais et des discriminations, la protection de la confidentialité et des données personnelles ;

- la conservation de métadonnées sur les données d'entraînement, parfois des données elles-mêmes, et des techniques utilisées pour la programmation de l'IA et son entrainement ;

- les informations sur la présence d'une IA et ses capacités et limitations ;

- des garanties sur la fiabilité et la précision des IA;

- la possibilité de supervision humaine, comme la surveillance, vérification, validation, désactivation ;

- Les circonstances d'utilisation de certaines applications d'IA comme l'identification biométrique à distance.

Des usages bénéfiques à la société

Au fond, les IA génératives ne sont que la matérialisation de l'intelligence collective mondiale, qui a accumulé et exposé publiquement des quantités considérables de connaissances grâce à l'Internet. Ces informations se retrouvent condensées pour servir d'inspiration à un outil conversationnel. C'est un cerveau planétaire collectif. Au même titre qu'une intelligence collective de groupe donne quasiment toujours de meilleurs résultats et de meilleures innovations qu'un individu isolé, les futures itérations de cette intelligence collective universelle auront les capacités d'améliorer de nombreux domaines.

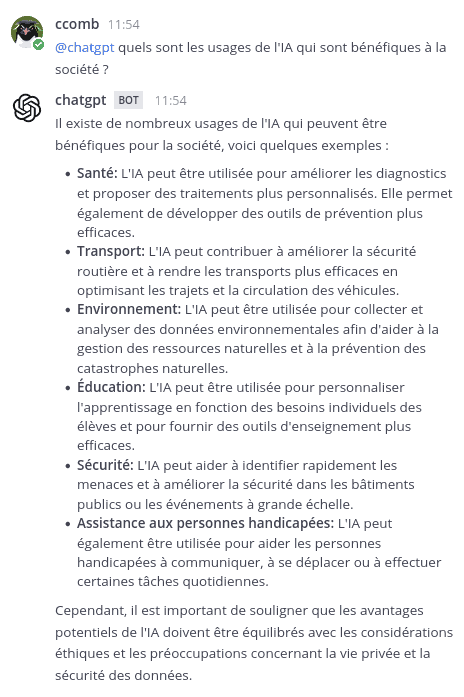

Pour savoir lesquels, demandons à ChatGPT lui-même (ici via une intégration dans un Mattermost d'entreprise) :

Sa dernière phrase reflète l'inquiétude présente initialement dans son corpus d'apprentissage.

Ensuite une rapide recherche :

Je trouve l'époque vraiment passionnante. Les opportunités sont immenses pour apprendre de nouvelles choses, créer, innover, résoudre des problèmes, aussi bien dans le public que le privé.